BBPE:字节级别的BPE分词技术解析与应用

元数据

- 分类: 自然语言处理 (NLP)

- 标签:BBPE, BPE, 分词技术, 文本压缩, 多语言处理

- 日期:2025年4月2日

BBPE:字节级别的BPE分词技术

字节级别的BPE(Byte-level BPE,简称BBPE)是一种改进的分词技术,它将传统BPE从字符级别扩展到字节级别。该方法尤其适用于处理噪声文本和字符丰富的语言(如中文和日语),在多语言处理和文本压缩等场景中表现出色。

BBPE的核心特点与优势

💡 BBPE的主要特点和优势如下:

-

词汇表更紧凑

- 通过基础词表使用256字节集(UTF-8编码),显著减少了稀有字符对词汇表的占用。

- 在多语言任务中,字节级别子词可以实现更高效的共享,即使字符集不重叠。

-

高效的压缩能力

- BBPE根据文本中的重复模式动态生成词汇表,适合处理大量重复内容的数据。

- 支持多种数据类型(如文本、图像等)并保持无损压缩。

-

灵活性与可解码性

- 压缩效果和词汇表大小可灵活调整,满足不同场景需求。

- 编码后的数据可以无损解码回原始数据。

BBPE的局限性与挑战

⚠️ 尽管BBPE有诸多优点,但也存在一些不足:

-

编码序列长度增加

- BBPE的编码序列可能略长于传统BPE,计算成本更高。

-

解码歧义问题

- 字节级别解码可能存在歧义,需要结合上下文信息和动态规划来确保解码结果的有效性。

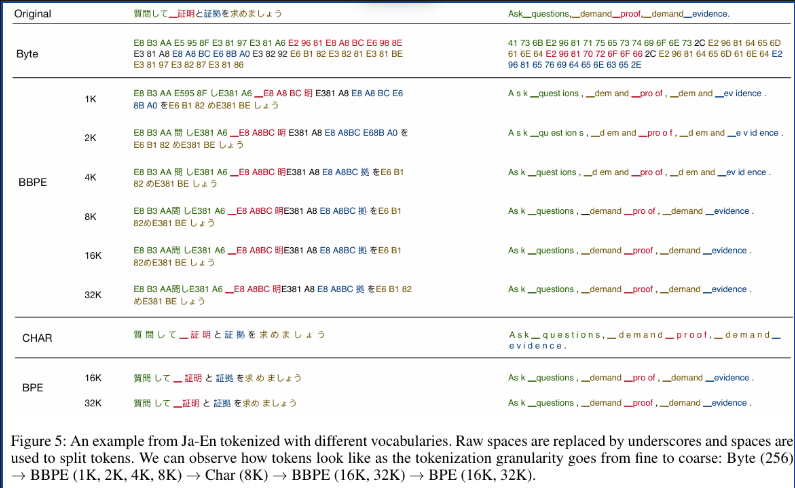

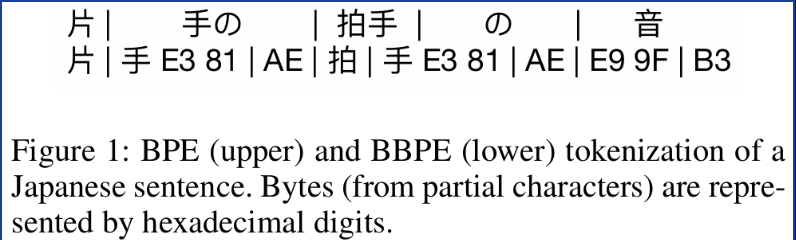

BBPE与BPE的对比

以下是BBPE与传统BPE在分词结果上的对比:

| 特性 | BBPE | BPE |

|---|---|---|

| 分词单位 | 字节级别 | 字符级别 |

| 词汇表大小 | 更小 | 较大 |

| 多语言共享能力 | 更强 | 较弱 |

| 编码序列长度 | 略长 | 较短 |

| 计算成本 | 较高 | 较低 |

📈 趋势预测:随着多语言模型和大规模数据处理需求的增长,BBPE在多语言共享和压缩效率上的优势将进一步推动其应用。

BBPE代码实现示例

以下是BBPE分词的核心代码实现示例:

split_words = [

[byte_encoder[b] for b in token.encode("utf-8")]

for token in re.findall(pat_str, data)

]

# 向词汇表中添加基本词汇

vocab = set(byte_encoder.values())

merges = []

# 构建词汇表,直到满足所需的词汇量

while len(vocab) < vocab_size:

print(len(vocab))

pair_freq = Counter()

# 找出最常见的一对

for split_word in split_words:

pair_freq.update(zip(split_word[:-1], split_word[1:]))

most_common_pair = pair_freq.most_common(1)[0][0]

# 更新词汇表和合并列表

# ...

常见错误提示

❗️ 在实际使用BBPE时,需注意以下问题:

- 上下文解码问题:未正确实现上下文信息融合可能导致解码结果不准确。

- 词汇表生成效率:大规模数据集上构建词汇表可能时间较长,应优化算法或使用并行处理。

行动清单

✅ 学习BBPE的理论基础与实现细节。

✅ 在多语言任务中试验BBPE,观察其紧凑性与共享能力。

✅ 探索BBPE在非文本数据(如图像)的应用潜力。

[思考] 板块

- BBPE是否能进一步优化以减少编码序列长度,同时保持其压缩性能?

- 在多模态任务(如图像+文本)中,BBPE是否能通过统一编码提升跨模态理解能力?

- 是否可以结合神经网络(如Transformer)动态调整BBPE的分词策略?

来源:本文内容基于论文《Neural Machine Translation with Byte-Level Subwords》及代码仓库https://gitee.com/wangyizhen/fairseq。

https://arxiv.org/pdf/1909.03341