位置内插法扩展语言模型上下文长度

元数据

分类:自然语言处理

标签:位置内插法、RoPE、上下文扩展、语言模型

日期:2025年3月5日

核心观点

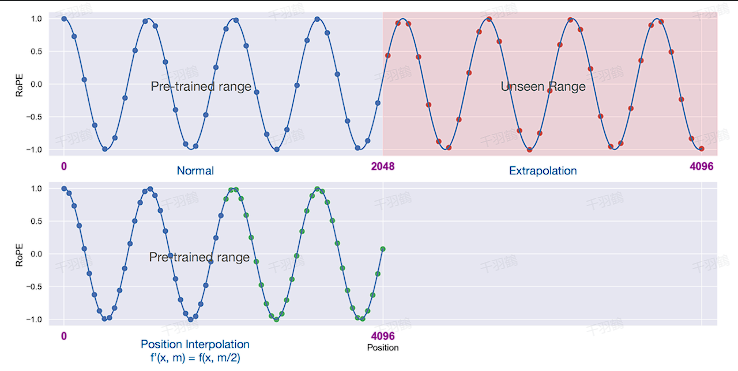

位置内插(Positional Interpolation,PI)是一种扩展语言模型上下文窗口长度的技术。通过将未见过的位置映射到模型训练时见过的位置,避免了直接外推导致的性能下降。这种方法在扩展上下文窗口时表现出较好的困惑度(Perplexity)指标,尤其是在微调后效果显著提升。

重点内容

RoPE的问题与位置内插法的解决方案

RoPE(相对位置编码)通过正弦和余弦函数嵌入位置信息,但直接外推会导致注意力分数(Attention Score)显著增加,影响模型性能。位置内插法通过缩放位置索引,将扩展的上下文长度映射到模型训练时支持的范围,避免了灾难性性能下降。

公式描述:

其中:

微调对效果的影响

✅ 步骤0(无微调):位置内插后,模型在扩展到8192上下文窗口时,困惑度 < 20,相比直接外推(困惑度 > 1000)有显著改善。

✅ 微调后:经过200步微调,模型超过了原始2048上下文窗口大小的性能;在1000步后,困惑度进一步降低,显示出语言建模能力的稳步提升。

困惑度指标的重要性

困惑度(Perplexity)是衡量语言模型性能的重要指标。公式如下:

困惑度越低,说明模型对下一个单词的预测越准确。

应用位置内插的操作步骤

- ✅ 确定目标上下文长度:设定扩展后的长度 $$L'$$。

- ✅ 计算缩放比例:使用公式 $$s = \frac{L}{L'}$$ 确定缩放因子。

- ✅ 映射位置索引:将目标位置 $$m$$ 映射至训练范围 $$g(m) = s \cdot m$$。

- ✅ 验证效果:测试模型困惑度并根据需求微调。

常见错误与警告

⚠ 直接外推问题:使用未见过的位置索引会导致注意力分数异常高,模型性能急剧下降。

⚠ 微调不足:未充分微调可能导致扩展后的上下文窗口性能未达到预期。

💡启发点

- 使用位置内插法可以有效扩展语言模型的上下文窗口,而无需重新训练整个模型。

- 微调是提升效果的关键,尤其是在大规模上下文扩展时。

📈趋势预测

随着自然语言处理任务对长上下文处理需求的增加,位置内插法可能成为主流技术之一,并与其他扩展方法(如混合位置编码)结合使用以进一步优化性能。

行动清单

- 测试位置内插法对不同语言模型的适用性。

- 比较微调与非微调情况下的性能差异。

- 探索与其他位置编码技术(如绝对位置编码)的结合方式。

[思考]板块

- 在扩展上下文窗口时,是否可以结合其他编码方式(如动态位置编码)进一步优化?

- 微调步骤是否可以进一步简化,以适应更多低资源场景?

- 如何利用位置内插法提升多模态任务中的上下文处理能力?

原始内容来源:关于位置内插法及其在语言模型中的应用分析(2023)。