模型打分与数据去重

元数据

分类:数据处理与机器学习

标签:数据清洗、预训练模型、去重算法

日期:2023-10-31

核心观点总结

在预训练模型开发过程中,数据质量直接影响模型性能。通过模型打分和数据去重,可以有效提升训练数据的质量。本文探讨了如何利用打分模型评估数据质量,以及在预训练阶段进行数据去重的具体方法和注意事项。

数据质量评估与打分

✅ 模型打分器的选择

- BERT模型优先:在相同大小下,BERT结构的表征能力优于Transformer-Decoder模型,因此推荐使用BERT类型模型进行微调。

- 强闭源模型:如GPT-4o,可以用于对训练数据进行打分。

⚠ 训练打分器的注意事项

- 不必追求打分器100%的准确率,"凑合能用"即可。

- 数据规模不必完全匹配:例如,32K语料只需用4K规模的打分器即可。

💡 启发点:打分器的训练时间和资源投入应适度,避免过度优化导致效率低下。

数据去重的三大类别

❗ 数据重复类型

-

训练数据集内部重复:

- 单个文档内部的重复(如重复行、段落、n-grams)。

- 多个文档之间的完全匹配或模糊匹配。

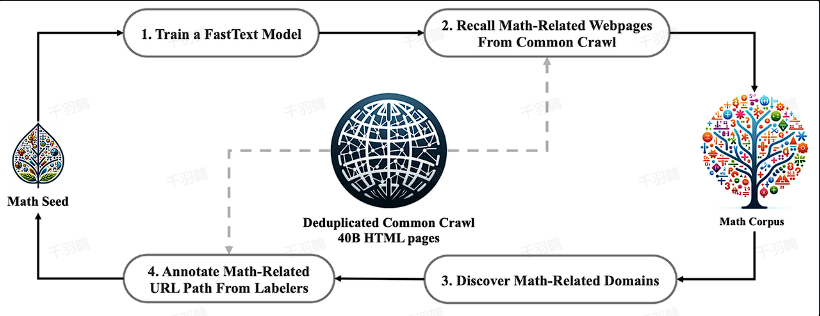

- 示例:CommonCrawl 和 T5 的 C4 数据集存在来源重复。

-

训练迭代设置的重复:

- 不同数据集采样时设定的重复轮次(Epochs)。

-

训练与测试集的重复:

- 测试集应从训练集移除相似数据,以避免影响评估结果。

数据去重流程

✅ 操作步骤

-

确定处理单元(Unit):

- 根据数据来源和特征选择基本处理单元。

- 示例:

- CommonCrawl:按行级别去重(Line-level)。

- Books3:按书籍覆盖率超过90%进行去重。

- Github代码:按文件级别完全匹配去重。

-

Unit自身去重:

- 分析单元内部是否存在大量重复内容(如重复行或段落)。

- 如果重复比例过高,则直接丢弃整个单元。

-

Unit之间去重:

- 检查多个单元之间是否存在完全匹配或模糊匹配重复。

常见错误与注意事项

⚠ 警告区块

- 误区1:过度依赖打分器的准确率,忽略其实际应用价值。

- 误区2:未对测试集和训练集进行严格去重,导致评估结果失真。

- 误区3:忽视单元内部质量,直接使用低质量数据。

📈 趋势预测

- 随着预训练模型规模扩大,数据清洗和去重算法将更加智能化,可能出现基于深度学习的自动化质量评估工具。

- 数据来源多样化将进一步增加去重难度,未来或需更复杂的模糊匹配算法。

[思考] 延伸问题

- 如何平衡数据清洗效率与模型性能提升之间的资源投入?

- 对于多语言预训练模型,是否需要针对不同语言定制化的去重策略?

- 是否可以通过生成式AI辅助更高效地完成数据质量评估?

行动清单

后续追踪

- 深入研究基于模糊匹配算法的数据去重方法。

- 调研现有闭源模型(如GPT系列)在数据质量评估中的应用案例。

- 开发通用型打分器以适配多类型数据集。

原文出处:《模型打分与数据去重在预训练中的应用》